字體:小 中 大

字體:小 中 大 |

|

|

|

| 2023/10/12 06:45:04瀏覽488|回應0|推薦5 | |

Explainable AI 是什麼?為什麼 AI 下判斷要可以解釋?

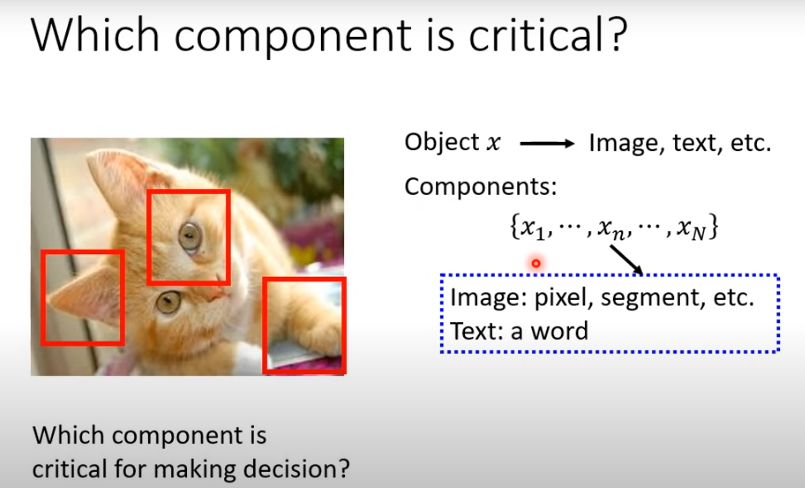

這篇文章非常有系統地說明了我之前屢次談到的,機器學習黑盒子AI的一個大問題!我第一次想到這個問題是因為我的影像辨識產品難免發生錯誤,客戶當然都能理解體諒,如此複雜的辨識軟體有一兩趴的錯誤是可以接受的!但是當然也都會好奇詢問:為何會錯? 和現場配置或影像品質有關嗎?或是我的軟體技術可以解決這個問題,替客戶的軟體升級改版嗎?如果我可以明確逐步分析報告錯誤的確實原因,那麼對策也會自然出現,客戶也會感覺安心。就像人生病了,但是很快就醫知道病因,也知道一定醫得好,就放心了! 反之,如果我是用無法分析辨識過程的機器學習黑盒子作辨識呢?我的專業形象就難保了!因為我對於事發經過,「AI」為何做此判斷的過程原因一無所知!如果買產品的客戶知道的跟我一樣多,那我存在的價值與意義何在呢?客戶直接跟黑盒子原廠網購就好了嘛! 這也是我一開始就不敢採用機器學習研發方案的主因之一!如果我用了,將會落入完全被黑盒子AI邊緣化的窘境!除非機器學習產品的效能直接就可以超越我原本的所有產品,根本不會出現任何錯誤,我就可以將自己簡化為推銷員即可!否則只會吹噓空洞的AI概念,卻無法解釋任何例外的RD等於廢物!想用ML、DL與CNN做影像辨識產品的同業們,你們不會擔心這種狀況嗎? 其實上述文章說的內容根本就是針對機器學習方法的盲點!也是揭開AI神秘面紗的一個學術活動,好像逼使占星師解釋他們算命結果的科學推理過程!讓這些ML、DL與CNN產出的AI不再享有神秘而被過度推崇的不合理地位!我認為這是讓這些以統計學為基底的AI導入正軌,真正與傳統科學重新結合攜手並進遲早必須做的事情! 所以大多數認為可以靠機器自行摸索得到解決方案的AI迷們必須深思了!AI究竟是要替真實世界的人類服務的!如果原本的人類世界就是依據科學理性運作的,AI也必須能夠自證他們的判斷決策是合理可靠的!我相信這個學術活動繼續推動下去,會讓AI詐騙不再能肆無忌憚的欺騙使用者! 簡單說就是:賣AI產品的人也是必須負責任的!只用AI的神祕大帽子遮醜蒙混過去是行不通的!你必須如下辨識一隻貓的示意圖一樣,透露出你為何判斷這是一隻貓的某些關鍵資訊,這也可以讓使用者看出AI黑盒子的品質高下:

當然對於我這種根本不用機器學習,以傳統科學概念設計AI產品(專家系統)的人來說,我是一定可以完整解釋我的每一個辨識步驟的!也就是客戶絕對可以完全信任理解我賣的AI產品!客戶跟深度學習影像辨識的AI廠商要不到的解釋,我隨時都可以說清楚講明白,也可以迅速修正錯誤升級改版!AI也可以完全透明的,你知道嗎?

|

|

| ( 心情隨筆|工作職場 ) |