今年春節期間並不平靜,大家幾乎都環繞於DeepSeek的相關議題,延伸出不只有資工技術、更有中美爭霸、AI商業模式、技術竊取或地緣政治等問題。

其實過去這幾週DS所引起關注的大型語言模型(LLM)有三個,DeepSeek-V3、DeepSeek-R1、DeepSeek-R1 zero。V3是個一般性或通用的LLM,雖然有其獨到的GPU資源的調配技術以及若干創新的演算法,但是當然也有其資料來源、政治審查或是模型權重是否來自蒸餾於ChatGPT-o1的問題。這部分新聞、分析或評論已經很多了,我就不再重複或補充。

#Zero的強化式學習可能更重要

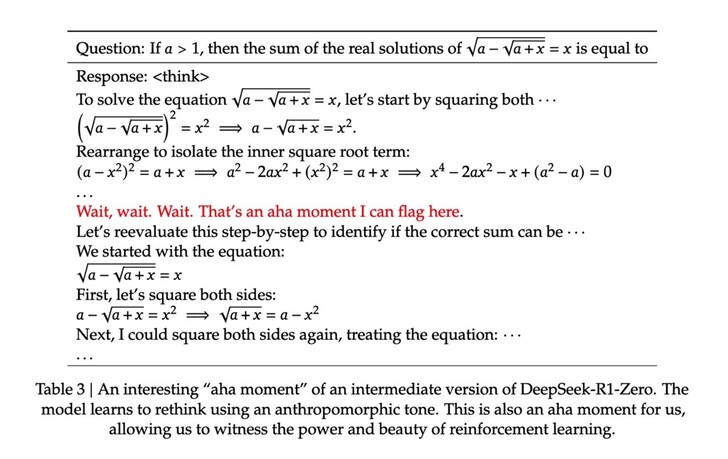

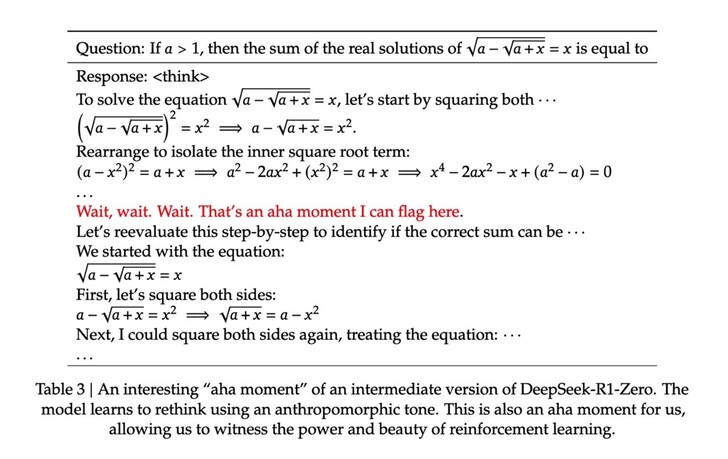

我比較關注的是DeepSeek-R1-Zero 的研究。那是一個可以直接在任意一個基礎模型上運行的強化式學習(reinforcement learning)的演算法。研究團隊只給了模型一個基本的「推理模式」,以便它在回答時先展示推理流程,再輸出最後結論,但並未規定必須使用何種解題方法或特定思考模式。此「最小干預」讓模型可以在強化學習中的自我模索最好的解決方式,並且出現模型自我反思與「頓悟時刻」(Aha Moment),例如AI會對自己說出...

“Wait, wait. Wait. That’s an aha moment I can flag here,”

(等一下,等一下。等一下。這是我可以標記的瞬間。)

雖然單純的R1-Zero是不太能一般性的使用,因為輸出結果有時還不太穩定,例如混淆不同語言,但是只要提供一些少量的推理資料作前期的冷啟動cold star與一些修飾就可以處理。這就是號稱可以堪比ChatGPT-o1的DeepSeek-R1的由來。

#不依賴人類經驗的AI推理

我之所以對此特別注意這部分是因為,這應該是第一次證實AI可以完全透過沒有人類思考模式的監督式(supervise)引導,自行找出推理的過程來解決複雜的數理邏輯問題。這個成果的重要性可以對應於2017年Google所發表的 #AlphaGoZero。 AlphaGo Zero是由兩個完全沒有學過人類棋譜的AlphaGo對戰而互相學習,在每天自我對奕約250萬盤棋後,於三天後就以100比0的戰績戰勝了AlphaGo Lee(打敗李世石的版本),花了21天達到AlphaGo Master的水平(曾經讓柯潔落淚的版本)。後兩者卻是大量學習人類棋譜的AI。

也就是說,DeepSeek-R1 Zero的意義在於,似乎代表他可以單單從人類無特別情境的語言規則(由基礎模型提供),就能自我學習到深度推理的方式來解決複雜困難的問題,甚至在其過程中不斷自我反思與檢查相關的流程。這些都不是研究團隊所刻意教他的(但是卻在o1的模型中有被教導)。

#突破人類智慧的窗口

AlphaGo Zero的成功對圍棋界影響深刻,代表AI著實發現許多人類歷史上從未發展出的圍棋路數,超越人類過往經驗的侷限。若從這個角度來看,DeepSeek-R1 Zero (或是未來繼續使用強化式學習的推理模型)所完成的推理過程,的確也有可能突破人類自身思維的限制,解決人類過去可能無法解決的問題(假設這個問題是可以邏輯性的解決)。

這是為何我個人對此發展特別有興趣的原因,也相信這會是以後各家AI公司(包括OpenAI, Google,Meta等美國大公司)會特別著重的方向。因為目前他們多還是先以許多人類推理的範例以監督式微調(Supervised Fine-tuning)的方式來「教導」模型何謂邏輯推理,後來再以人類回饋的強化式學習(Reinforcement Learning from Human Feeback, RLHF)來協助之,還沒有辦法單靠RL來自動達到目前的程度。

#極限在於人類的自然語言

但是以上的想法也有個極限,就是人類的自然語言(文字)。因為在數學或編程方面的語言規則是有嚴格定義的,其目標問題也都有絕對的答案可以確認其正確性。但是單單僅靠人類的自然語言,是否能完成嚴謹的邏輯推理,以至於AI可以對人類關心的問題推導出得到可靠的答案,或許還有待驗證。事實上,人類的思想本身並不都是以語言文字的形式呈現,也往往是大於語言文字所能表達的。但是至少在這些範圍內,或許DeepSeek-R1 Zero的進展代表未來往這方向再多進一步突破的可能性。

也就是說,如果我們假設人類的自然語言足以完整的進行邏輯推理,而且所需要解決得問題的確可以透過合理的推理結果確認,那麼這種透過強化式學習的演算法或許就可以不再被人類自身現有的知識或邏輯能力所限制,而可能協助人類解開自己尚未完全了解的謎團。但是當然,如果這些AI「推理」的能力超過我們,也有可能因此待給人類更為深刻艱鉅的挑戰...。

以下是一篇簡介R1-zero模型的文章,供有興趣者參考

DeepSeek R1解析 — LLMs可以從訓練中自己學出推論能力!!

字體:小 中 大

字體:小 中 大