字體:小 中 大

字體:小 中 大 |

|

|

|

| 2024/11/29 07:49:32瀏覽568|回應0|推薦7 | |

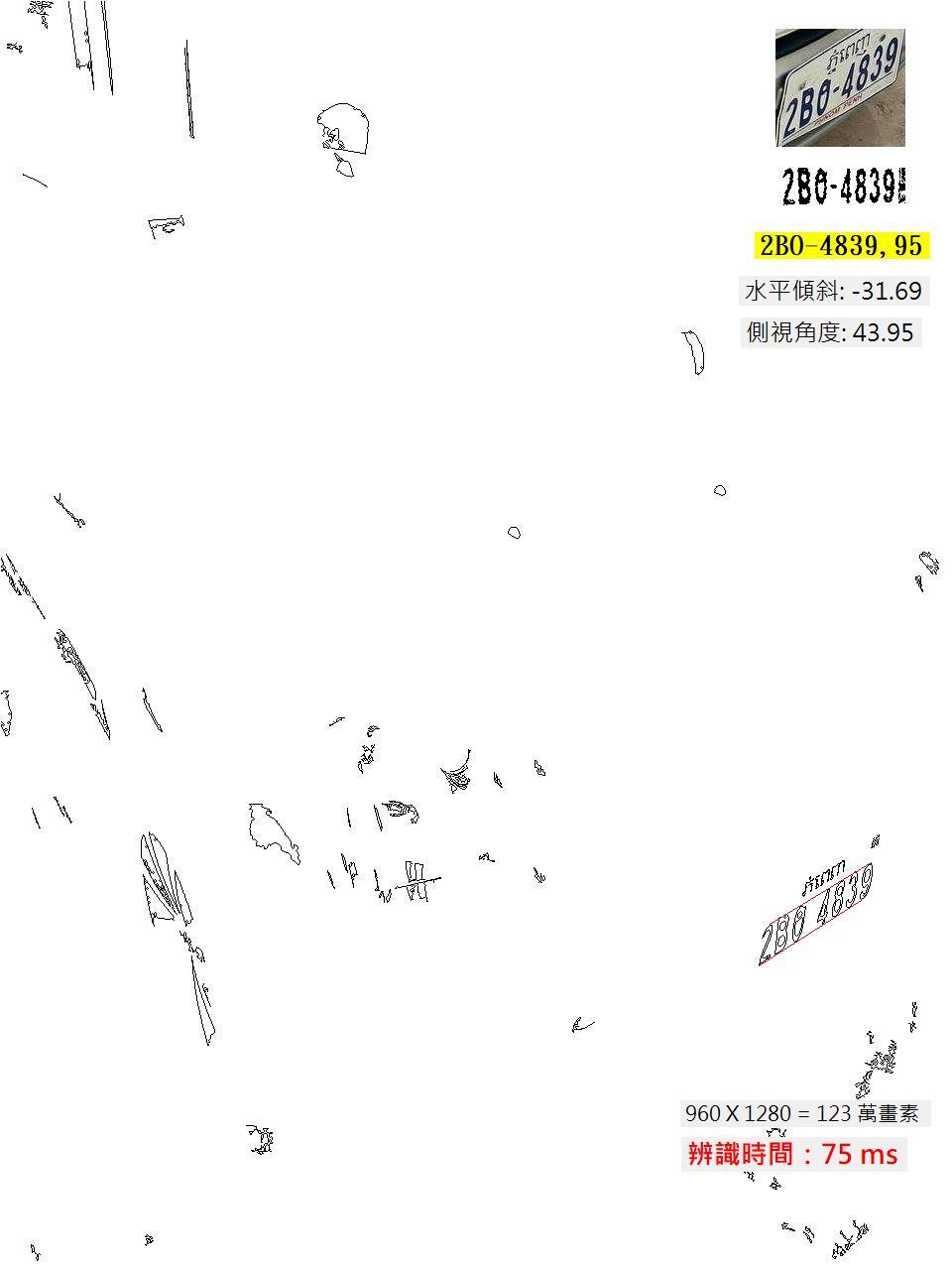

最近繼續研究東南亞車牌的辨識,我辨識變形車牌的能力也逐漸在柬埔寨的版本中展現了!這是一個水平傾斜到31.69度,側視角度達43.95度的案例,目前已經可以正確辨識了,雖然距離台灣版的處理能力還有一些差距,但是應該已經達到讓客戶可以方便使用,不必太緊張焦慮隨時要擔心拍攝角度的程度了! 我想提醒大家注意的是:即使這是一個已經算偏離正面視角很多,不可能用一般假設車牌是正面拍攝的演算法來辨識的案例,我的辨識速度還是幾乎跟完全正面的案例一樣快!123萬畫素的影像只需要75毫秒!我沒有使用除了演算法之外的任何加速軟硬體措施,當然也沒用GPU,這應該會讓那些吹噓AI影像辨識的專家們汗顏! 其實影像辨識的難度就在變數的多寡,如果是正面拍攝的清晰乾淨的車牌特寫,任何高中生套用幾個OpenCV的函數組裝一下就可以辨識率很高了!但是正常情況下,我們使用車牌辨識的方式一定沒有這麼簡單,拍攝時不會只拍車牌本身,至少會包括整輛車子,那背景就複雜了,加上不可能總是可以正面拍攝,車牌就會變形,不會是標準的矩形了!低階的辨識軟體會連車牌位置都抓不到! 這時候玩AI的人就會開始興奮了!因為找到複雜背景中的目標是CNN也就是YOLO等技術最專長的事!他們總是炫耀在GPU加持之下,可以在街景中很快找到車牌!但是請問:如果是如上圖這樣高角度歪斜的車牌,YOLO找得到嗎?CNN是用特徵矩陣掃描找車牌的,所以必須假設車牌得是一個矩形才行!如果變成很歪斜的任意四邊形呢,YOLO還找得到嗎?我是沒看過這種展示,你看過嗎? 即使可以找到歪斜變形的車牌,要真的辨識出其中的每個字元也還是個大問題!因為我們要確認是甚麼字一定必須有所根據,正面的影像拿標準字模比對就可以了,任意變形的字呢?如果用機器學習或深度學習的角度思考,你要辨識出任一角度變形的字元,請問要多少資料來訓練?訓練時間不是會變成無限大嗎? 即使深度學習真的可以訓練成功數十個角度的變形字元模型,加上一點誤差容忍度就可以辨識出大部分變形的字元,但是很顯然需要的辨識時間一定會比辨識正面車牌影像要長很多!更可怕的應該是訓練開發這個多角度辨識模型的成本會高得嚇人!也會非常耗時。 換言之,如果你想用CNN與深度學習的模式,做出跟我前面展示的一樣功能的軟體,你需要的資金至少是我的數十倍!執行辨識時需要的電腦設備成本也會多好幾倍!辨識時間還一定比我的產品慢很多!不服氣就做一個類似產品來PK嘛!我嗆聲挑戰好多年了!始終沒有回應!是我的份量不夠?還是AI專家畏戰不敢面對?大家自己判斷!

我最討厭的事情就是故弄玄虛搞神祕!我不會像那些玩ML、DL與CNN的AI專家一樣專打迷糊仗,總是高談闊論讓大家以為那種AI影像辨識希望無窮?但炒作了十幾年,就是一直拿不出可以商用實用的產品?如果他們可以做到他們宣稱的目標,我早就無法以車牌辨識為生了!不是嗎?我是完全不用那些AI技術的! 我可以直接告訴我的讀者、客戶與競爭對手我是怎麼作到的!就像上圖一樣,我就是用OCR技術直接找到字元,進一步找到成排的字元目標,再依據字元群組描繪出可能的車牌四邊,接著作幾何修正讓歪斜車牌轉正,接著就是跟標準字模比對,歪斜車牌就可以辨識出來了!處理歪斜狀況的程式,就是主程序SOP的一部份,所以不論歪不歪辨識時間都是一樣的!那是我軟體的本能,不是外加的功能! 我是完全不想隱藏「核心」技術的!真的就跟我上面描述的一模一樣,任何學過傳統影像辨識技術的人都可以模仿,我甚至都寫了書說清楚了!我不會擔心因此失去技術領先優勢的!因為我自信只要我還活著在工作,看到這些資訊的人也只是跟隨我的腳步,很難超越我的! 而且除了辨識主軸之外有太多細節技術需要很多時間摸索試驗,等模仿追隨者做完這些瑣事,我已經進化到另一層樓了!我的生意不會因此受到威脅的!我勇於自己揭露核心技術,目的是告訴大家:傳統影像辨識技術沒有不好,沒有落伍,甚至依舊遠遠領先目前過度炒作的ML、DL與CNN等所謂的AI技術!我希望經過我的努力提供事實資訊,更多人可以選擇更合理有效的影像辨識解決方案!讓那些害死人不賠命的AI詐騙的傷害可以越少越好! |

|

| ( 心情隨筆|工作職場 ) |