字體:小 中 大

字體:小 中 大 |

|

|

|

| 2022/10/08 03:15:55瀏覽1528|回應0|推薦8 | |

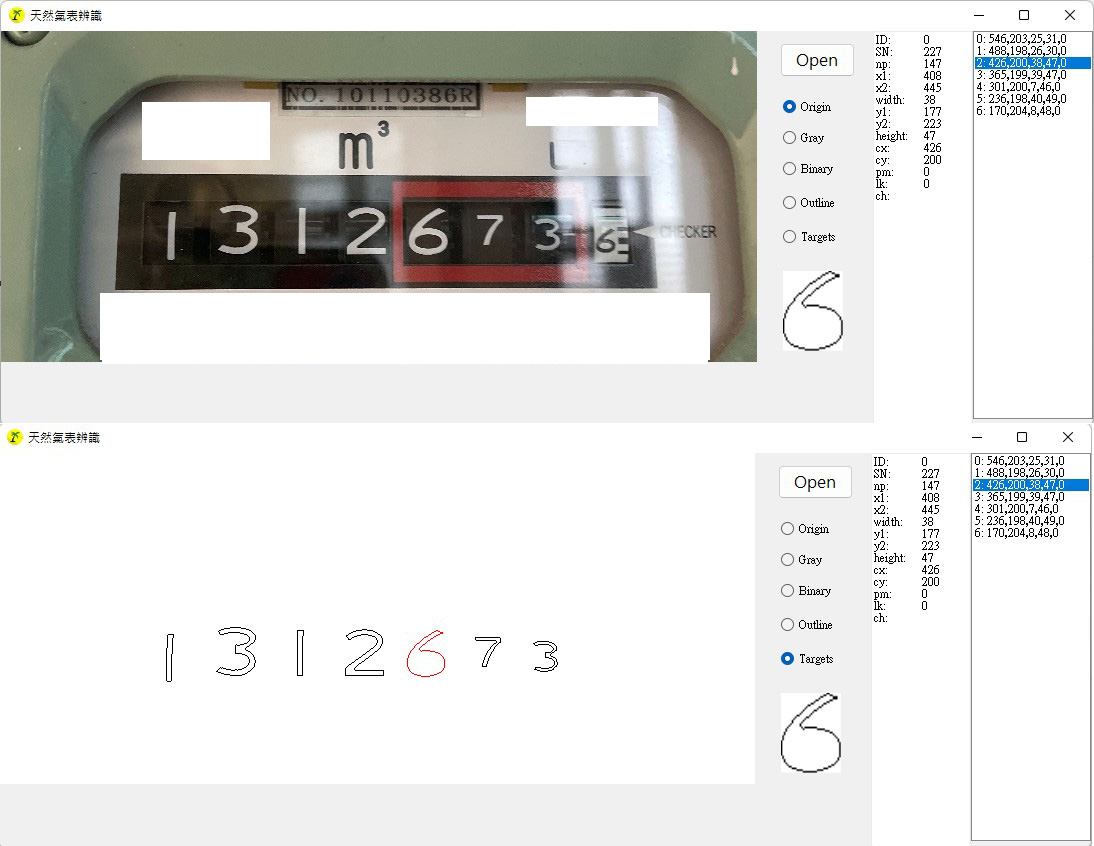

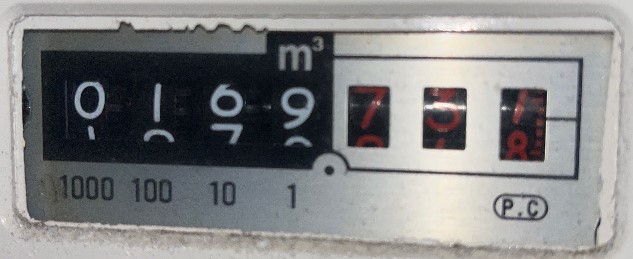

現在的CNN類神經網路學派已經將OCR技術視若敝屣了!所謂的OCR就是經過傳統的二值化與輪廓化處理,將影像中可能的目標獨立切割出來!如上圖就是一個尷尬但常見的例子,理應獨立被切割的字元目標,706都沒問題,但是1就有點麻煩?轉盤上方的亮白線與字元沾連了,拿這個形狀去比對可能的數字當然比較像是7或T,絕對不是1了! 這還是比較好的狀況,如果這個區塊與背景中更大範圍的白色區域連通了!那就連這個還算獨立的目標都抓不到了!在真實影像中這是很難處理卻又屢見不顯的問題。所以傳統的影像辨識專家就面臨了一個重要的抉擇:是要堅持OCR切割出合理目標字元的策略?還是乾脆放棄!不找封閉曲線的目標了,直接用更低階的特徵,以機率統計的方式來「猜測」目標位置了! 我就是堅持繼續OCR的學派,其實已經變成瀕臨絕種的生物了!CNN的特徵搜尋統計方式已經變成檯面上影像辨識的主流技術。但是我這些年一直有具體的進展,不斷的研發出可以補救OCR這個缺點的演算法!譬如上例,我只要略為「喬」一下,就可以發現忽略上面一點資訊後1字的符合度遠高於奇怪的7字?既然知道目標一定是數字當然就會判定是1了! 事實上,我知道在實用的影像辨識開發領域我並不孤單!真正在市場上賣的影像辨識軟體都還是我的同儕夥伴,CNN才是未經充分市場考驗肯定的不穩定科技!這個你們知道嗎?所以想學影像辨識的人別衝過頭了!在影像辨識領域,OCR絕對還是主要的支柱,要靠CNN當家?穩定性與辨識準確率都是遠遠不如OCR的! 最可怕的其實是運算量!CNN的運算需求量實在高出OCR太多倍了!在成本上就是絕對不合理的研究方向!現在很多人討論GPU或邊緣運算的使用,不要以為那是較先進的科技!其實是因為CNN與機器學習的這些演算法需要太多浮濫的計算,他們不思從運算原理端解決,卻要環境付出代價?太不環保了!

所謂的目標切不開,事出必有因,如上圖的案例,我們知道轉盤式的儀器就是會有過渡期的狀況,那就嘗試做一點合理的目標切割縮放甚至填補可能缺損的筆劃即可!一下子就算出最佳結果了!不必用GPU的!其實你也不知道該怎麼分散CNN運算的?但是我的邏輯卻是誰都可以聽懂的!即使沒學過影像辨識的人! CNN就是所謂的類神經網路,他們強調是模仿人類或生物的神經元反射,好像暗示他們比較接近人類的思考方式?其實那只是膝蓋反射,距離「智慧」與「思考」方式與過程是很遙遠的!反而是OCR的技術概念比較接近人類辨識目標的「認知」過程,數十年來也早就有很好的成果!根本沒有CNN時,OCR的影像辨識率就很好了!至今CNN都還沒證明他們可以把車牌辨識得更精準! 所以你們認為影像辨識的合理未來是我走的路?堅持OCR的持續演進?還是玩CNN呢?我選了我的路,目前也過得很好!還越來越好!如果你玩CNN開始感到很困惑無力時,可以回頭看看我是怎麼作的!這個天然氣表的辨識核心我只做了一周就95%了!用OCR是鐵定有解的!還很經濟快速!用CNN與ML呢?我就不知道了!你知道嗎?如果知道,歡迎你來此宣揚理念打廣告!但是不要騙人就好! |

|

| ( 知識學習|科學百科 ) |