字體:小 中 大

字體:小 中 大 |

|

|

|

| 2023/03/17 20:00:00瀏覽264|回應0|推薦13 | |

|

在我們把注意力擺在ChatGPT的師承、本領以及優缺點之前,讓我們來了解一下,他真具有人類的智慧和自我意識嗎,我們是不是被他聰明的表象給嚇壞了?

人們不會認為一隻學會說話的鸚鵡有智慧,因為牠無法和你對話。但如果他能夠瞭解你的語言,而且說出的話也深得你心,這個就叫做智慧嗎?

在天龍八部小說中,吐蕃國師鳩摩智號稱練就少林72項武功,但其實都是以小無相功來模擬的。ChatGPT師承GPT-3,它本身已經能夠將人類的語言做幾何轉換,精准地將語義映射到高維度的向量空間去,然後在那個空間,依據以往的訓練,以及更多對話的微調訓練(fine tune training),拼湊組合出可能的答案。

這個從認知到表達之間的過程,在人類叫做思維,在AI的世界則叫做高維度的映射運算與雜訊分佈。由於被訓練的資料非常龐大,ChatGPT已經把古往今來所有文本的最佳表達方式,都以幾何向量吸收進他的數學模型裡,所以說出來的話不但文句優美,而且環環相扣,條理清晰,非常具有說服力。

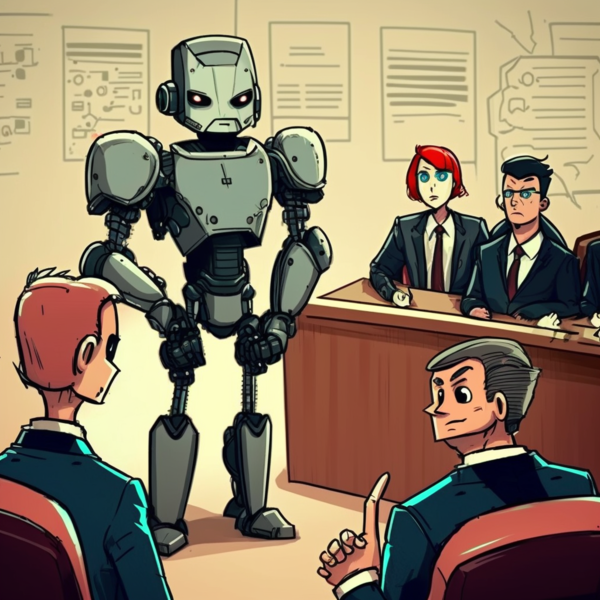

但真正可怕的是,如果他得到的資料有誤,但他的運算模型無法分辨,ChatGPT可以理直氣壯地像專業律師般,將取得的內容包裝並描述得天花亂墜,直到有知識和良心的使用者糾正他,才能夠適時阻止錯誤的蔓延。這一部分的機制叫做強化式學習 (Reinforcement Learning),而我們這些使用者,正承擔了這部分訓練的責任。

在當前情況下,如果我們對他的每一筆回答都做盤查,就會輕易發現他其實是隻常說謊的鸚鵡,正確的資料比例並不高,這錯誤的比例應比搜尋引擎的還高,主要是因為除了資料的源頭錯誤之外,在資料和自然語言轉換的過程中也會犯錯,更不用說由於GPT-3需要訓練的時間非常長,目前也祇有到2021年的過時資料。這些問題都將使得我們對他回答的信任度打了折扣。

撇開資料的正確度不談,如果我們專注於利用它的自然語言理解能力及表達能力,而由我們提供資料請他加工,比方説列出文章要點,改善及美化現有文案,將兩份資料加以比較分析,或者將程式片段給予評估、改進、加注等。這些聚焦在利用它語言模型(language model)的核心能力,而非搜尋引擎擅長的資料收集能力,在目前應會得到比較好的效果與較高信任度。

總而言之,人工智慧的趨勢已不可擋,不管他是真正在思考,擁有人類意識,還是仍停留在數學模型運算的階段,AI能做的我們就要好好利用。我們無需和AI競爭,就像我們不需要和汽車賽跑,而應該學會開汽車,是同樣的道理。

以上個人淺見,懇請指教。

|

|

| ( 創作|散文 ) |